Obscura No.7 - 一台能看见未来的望远镜

项目链接

看见未来的望远镜

在构思UCL的硕士毕业设计的时候,我一直在想一个问题:

“为什么我们明知道气候变化的风险,却依然难以真正感受到它?”

在学术世界里,我们拥有大量预测模型和环境数据,但它们往往只停留在专家圈层。图表、指标、PDF报告——这些形式都无法让公众产生共鸣。

我想做一件事:让未来被看见、被想象、被讨论。

于是我开始构思一个不是去观察现实,而是去生成“未来的景象”的项目。

我把它命名为 Obscura No.7,一台能看见未来的望远镜。

背景:为什么我要做它

在学习“智慧城市”和“环境预测”时,我常被一个矛盾困扰:

我们拥有越来越多的气候数据、模型与政策工具,但这些信息往往停留在专家层面。

公众难以理解,也难以被触动。

很多预测模型能告诉我们“未来将升温2度”或“洪水风险提升10%”,但这些数字太抽象。

我开始思考——

能否让人们看见数据的后果,而不是只看数字?

能否让一台机器,把“预测”变成“体验”?

于是,我设计了 Obscura No.7:

一台能将环境数据、AI预测与生成艺术结合起来的望远镜。

我希望它不仅是一件设备,更是一种媒介——让人们在与AI互动的过程中,重新感知“未来”这件事。

概念设计:Obscura No.7 是什么?

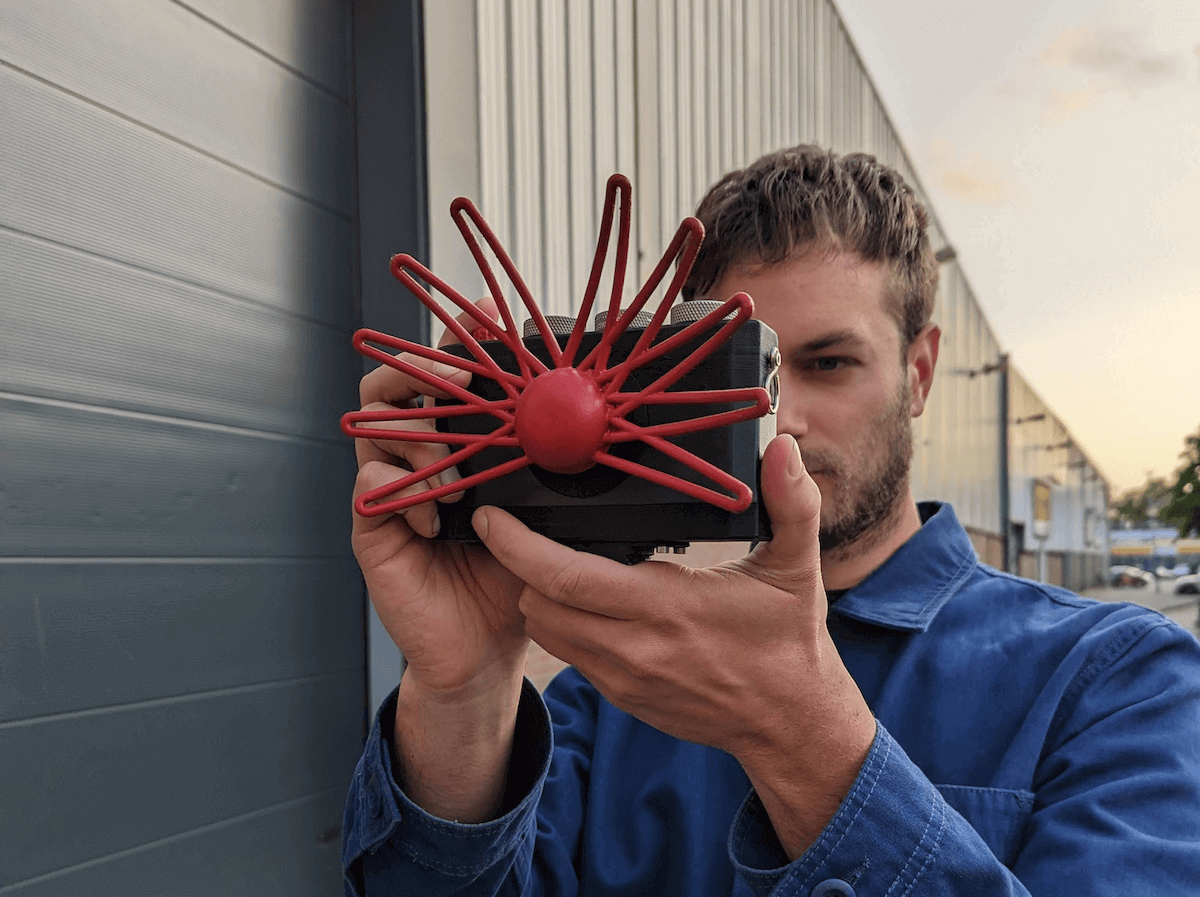

Obscura No.7 的概念灵感最初来自 Paragraphica —— 一台由设计师 Bjørn Karmann 打造的“AI照相机”。

这台相机没有镜头,却能根据当前位置、天气和时间,通过提示词生成一张“此刻的影像”。

我非常喜欢它那种“用数据去看世界”的想法:它不是捕捉现实,而是让环境数据成为感知的媒介。

在这个基础上,我开始思考:

如果一台机器不只是“记录现在”,而是“生成未来”呢?

于是,我为 Obscura No.7 加入了两个全新的维度:时间(Time) 和 距离(Distance)。

用户可以通过旋转两个机械旋钮,选择未来的年份与观察的范围。

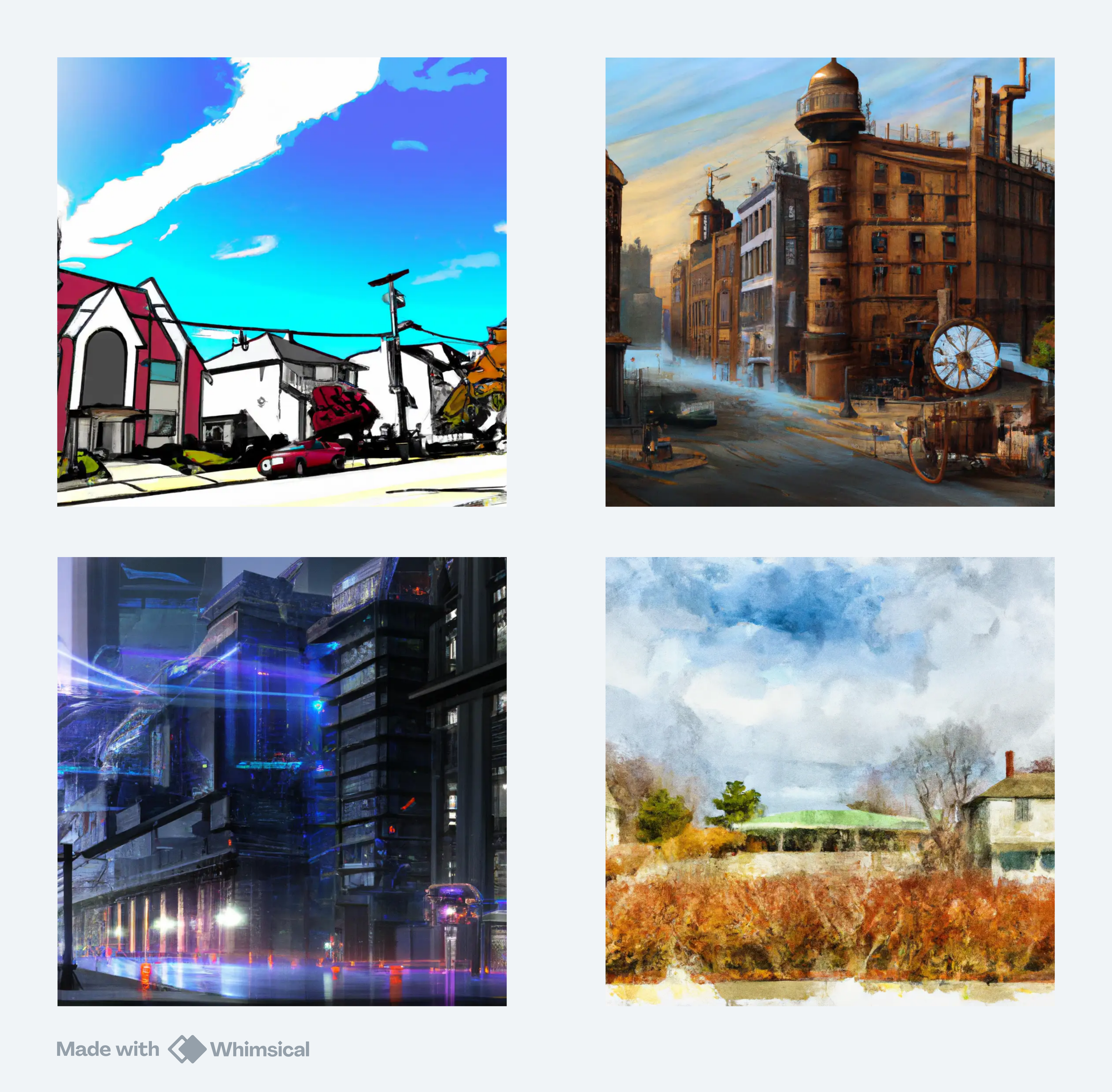

望远镜便会根据所选参数,调用环境与气候预测模型,生成一幅特定时间、特定地点的“未来图景”。

相比 Paragraphica 的“静态感知”,Obscura No.7 更像是一种“动态推演”——

它不是告诉你现在的样子,而是邀请你去想象未来可能的样子。

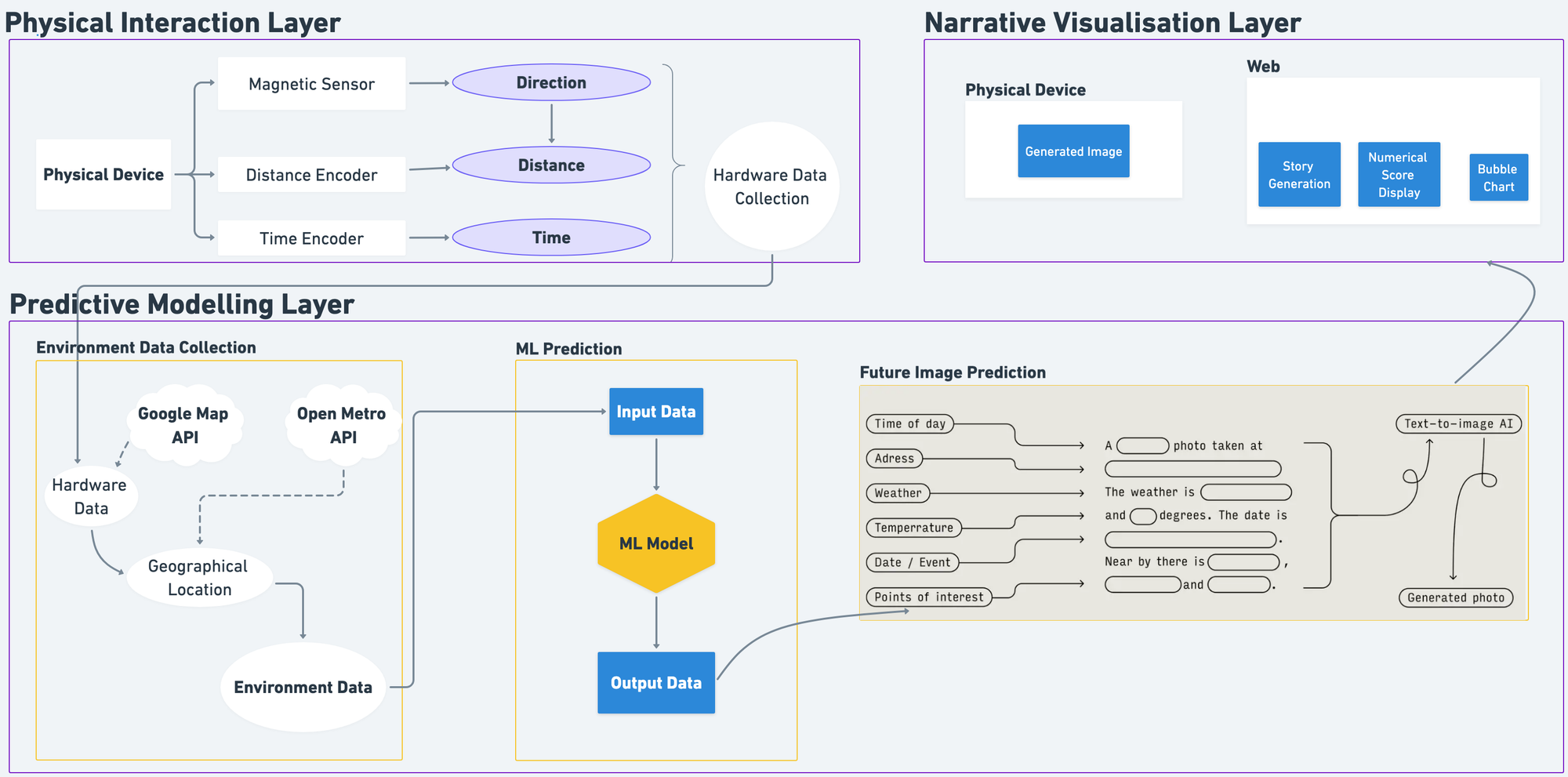

简单来说,Obscura No.7 是一个由三层系统组成的 AI 装置:

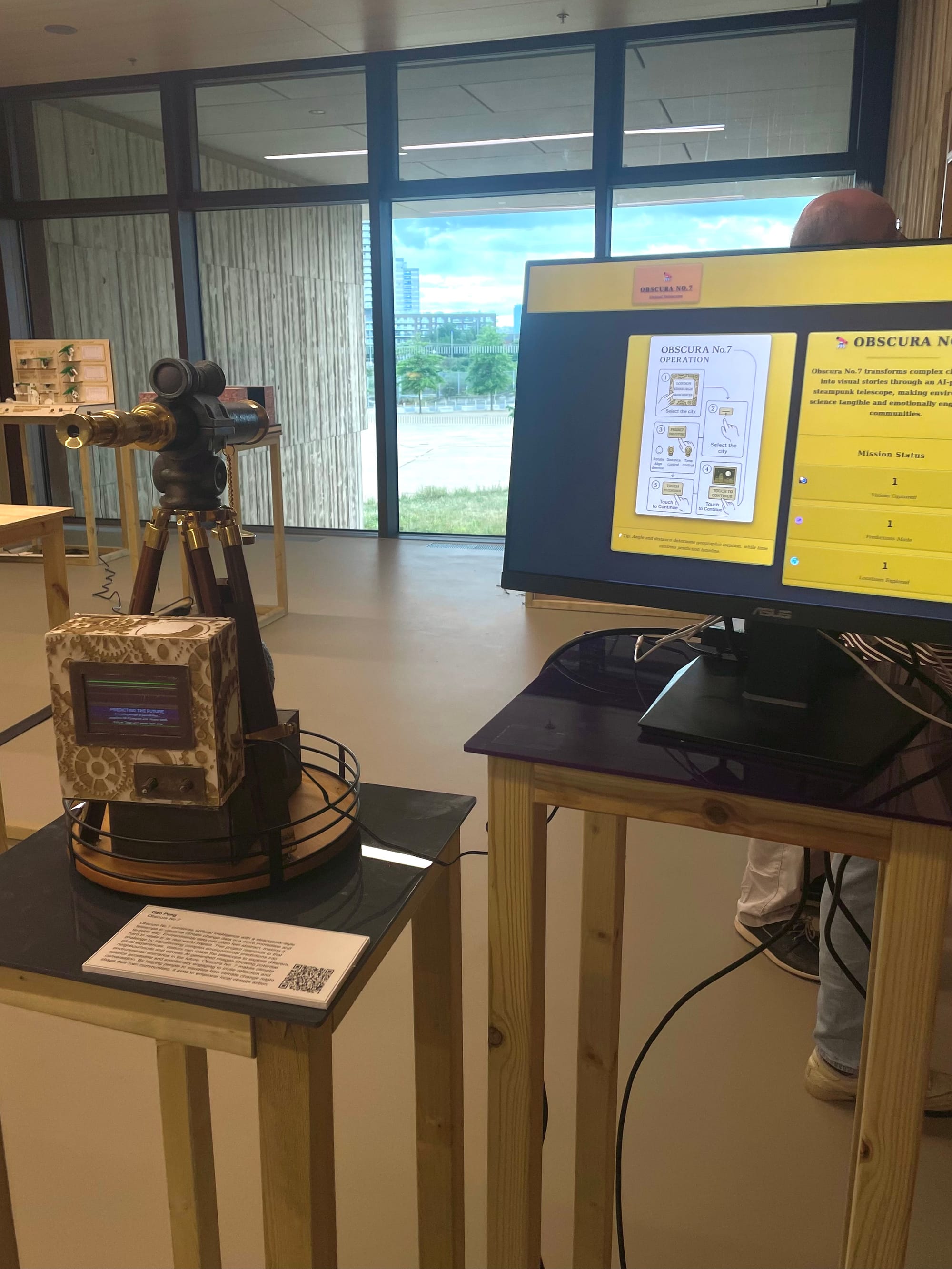

- 物理交互层(Physical Interaction Layer) —— 一台复古风格的望远镜,连接树莓派、编码器与触摸屏,用户可以通过旋钮选择“距离”和“时间”,并直接在屏幕上看到生成的画面;

- 预测建模层(Predictive Modelling Layer) —— 基于机器学习模型(随机森林、LSTM等)对未来气候、地理与经济环境进行预测;

- 叙事可视化层(Narrative Visualisation Layer) —— 将预测结果转化为图像、文字叙事与可解释性图表,让每一幅“未来画面”都附带“为什么是这样”的答案。

通过这三层的闭环,系统能够从用户的输入出发,生成可解释的未来场景。

而在交互层面,它不再是一串数据,而是一段故事——一个可被“观看”的未来。

工程实现:从代码到实体

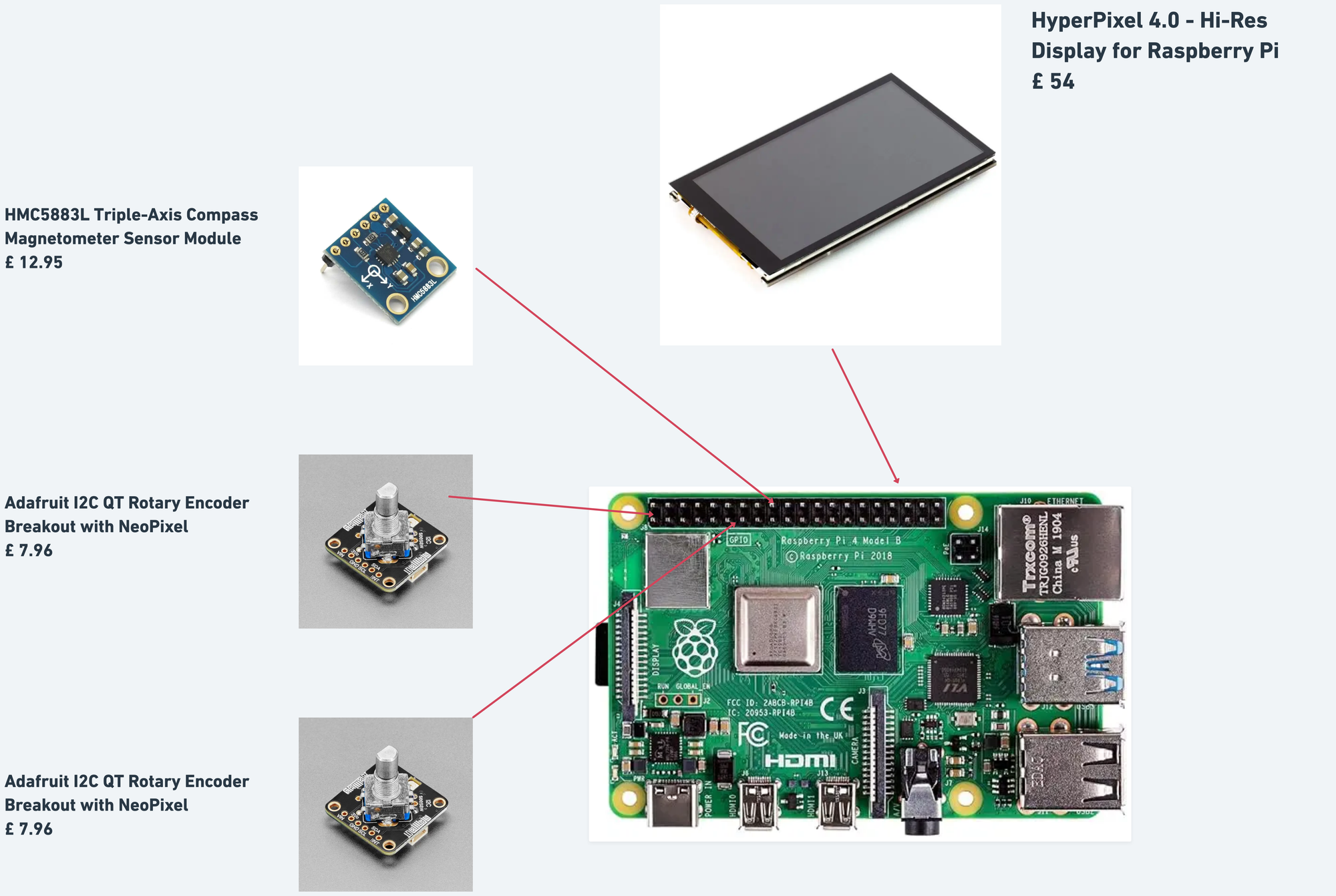

1. 硬件层:让交互更直觉

整机的核心是一块 树莓派4B(4GB RAM),搭配 HyperPixel触摸屏 与两个 Adafruit旋钮编码器。

旋钮分别控制“距离”(0–50公里)和“时间”(0–200年),用户可以像调焦一样设定要观察的未来范围。

最初我计划用GPS模块实现定位,但在室内展览环境中信号极差。

于是我改为使用 电子罗盘(HMC5883L)+旋钮输入 的组合:罗盘负责方向,旋钮定义距离,两者共同确定一个空间点。

随后通过 Open-Meteo API 获取该点的气象数据,再调用 Google API 提取地理信息。

这种“混合定位”方法既绕过了信号限制,又保留了空间语境。

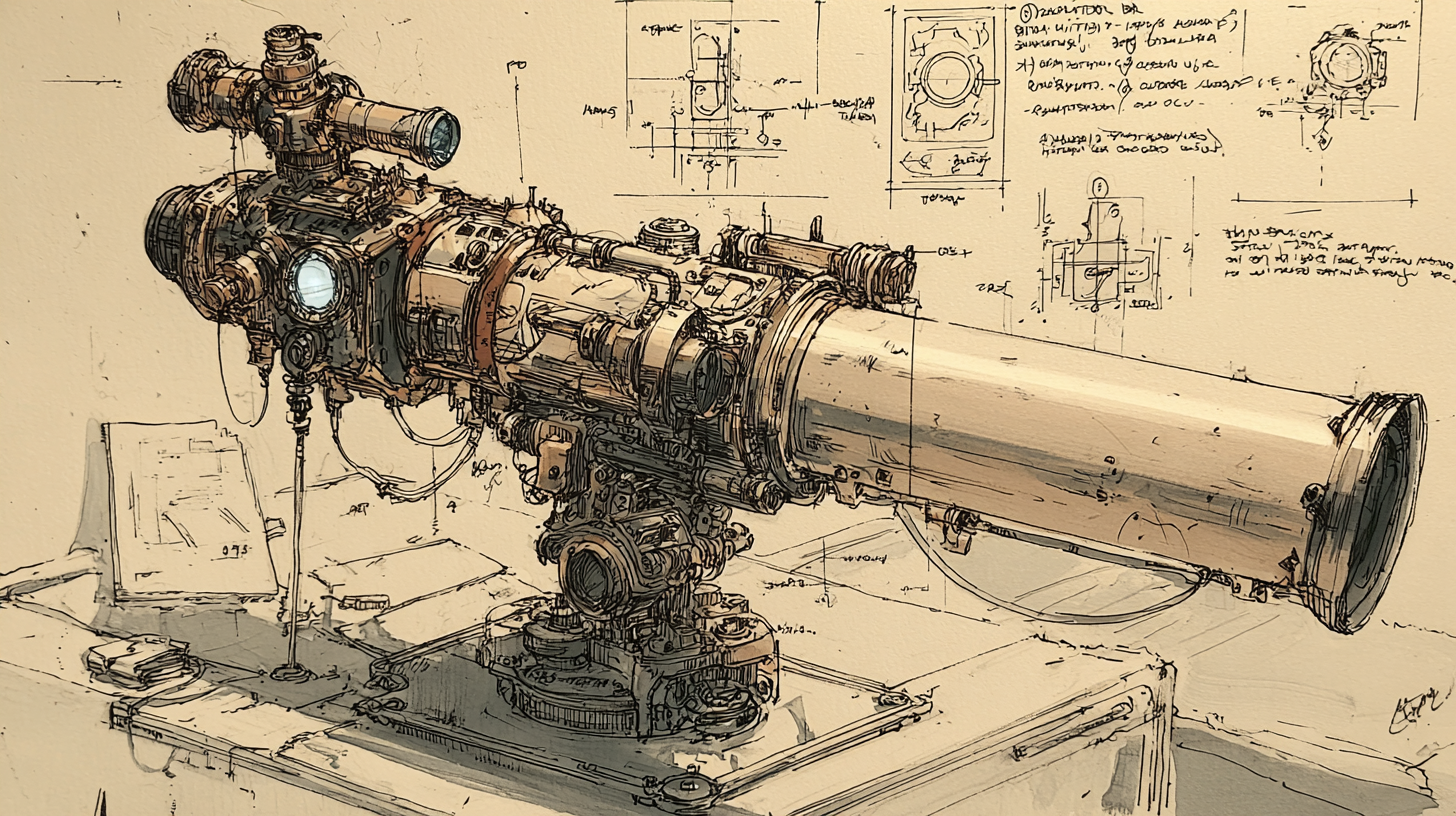

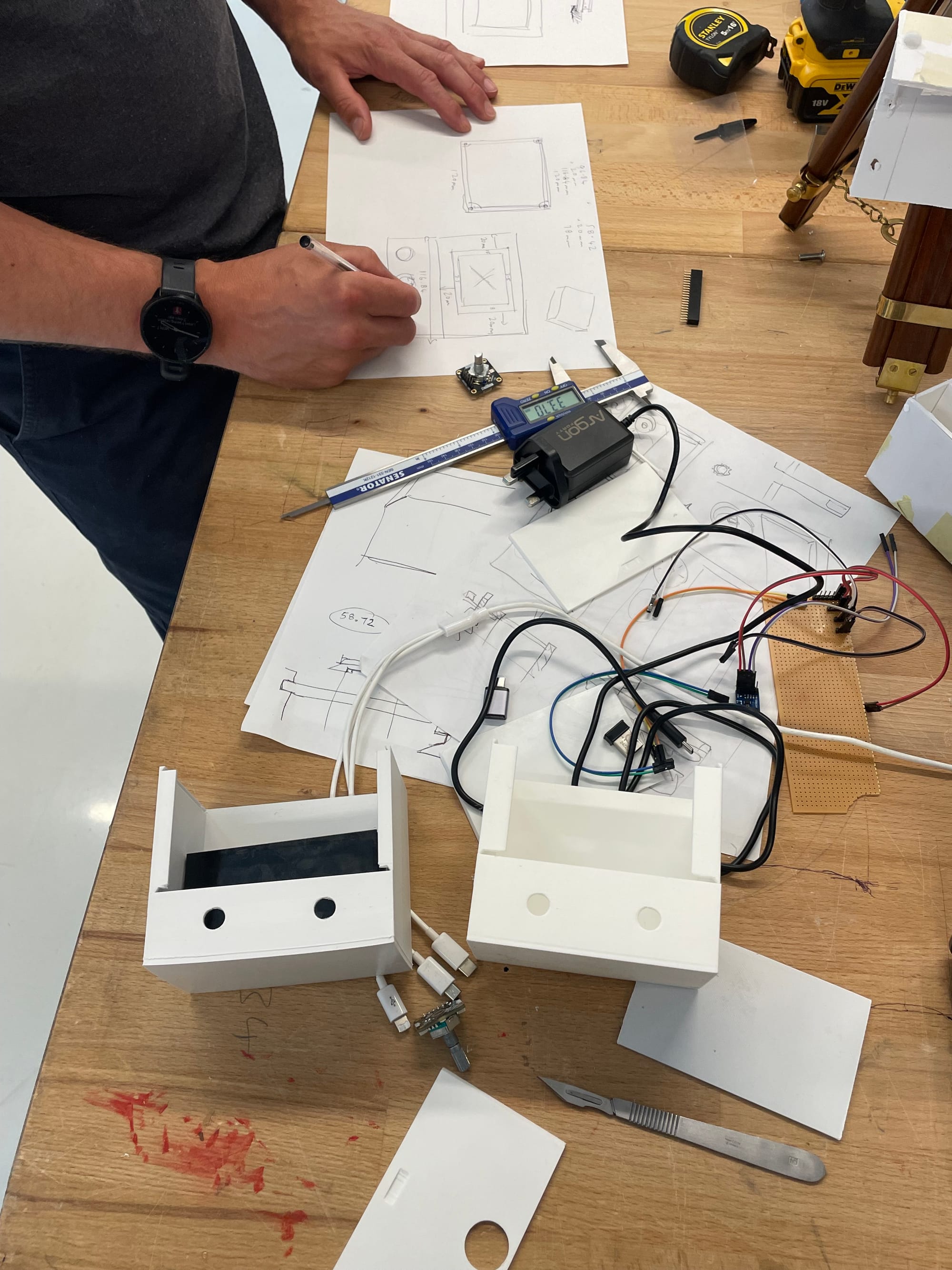

在外观设计上,我选择了复古蒸汽朋克风格:

主箱体在 Fusion 360 中建模,Bamboo 打印机打印,外层包裹镭雕纸板与仿旧色涂装。

望远镜与底座通过 Lazy Susan 转盘连接,既稳定又可旋转。

这一切都是为了让交互更自然——当你转动它时,感觉就像真的在“瞄准未来”。

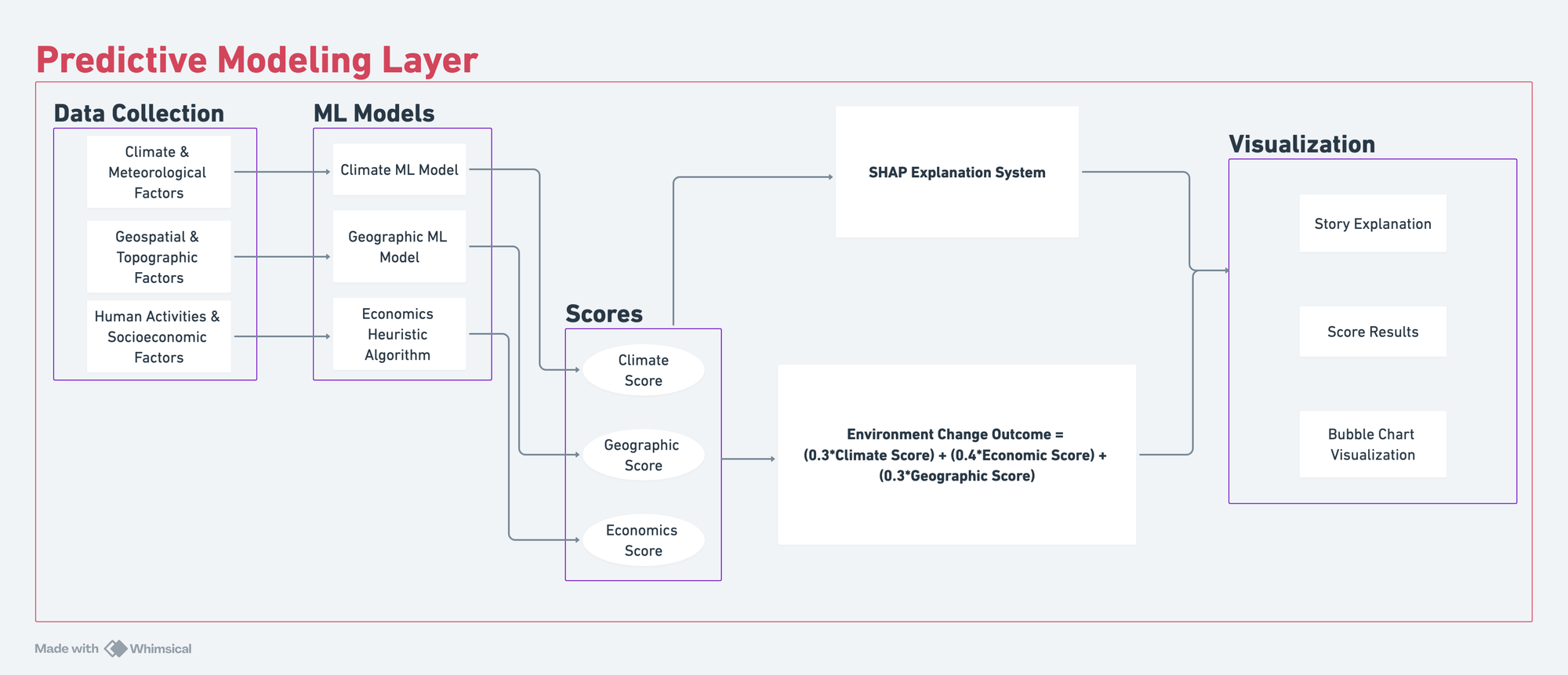

2. 预测层:让AI变得“可解释”

我不希望系统只是一个“黑箱”。

因此我引入了 SHAP(Shapley Additive Explanations) 方法[1],让预测结果可以被分解和解释。

预测层由三大维度构成:

- 气候与气象因子(温度、湿度、风速、蒸散量等)

- 人类活动与经济因子(NO₂、人口密度、GVA、基础设施等)

- 地理与地形因子(土壤温度、湿度、洪水风险等)

每个维度由不同模型预测,再通过加权公式融合成一个“环境变化指数(ECO)”。

SHAP 则负责追踪每个变量对预测结果的贡献,让“为什么会这样”变得可视化。

比如当系统预测“未来50年的斯特拉特福德,伦敦环境将恶化”,

SHAP会告诉你:

60%的影响来自CO₂上升,20%来自土壤干化,10%来自城市热岛效应。

这不仅是数据分析,更是一种“解释型设计”——AI不再只是输出结果,而是在对话。

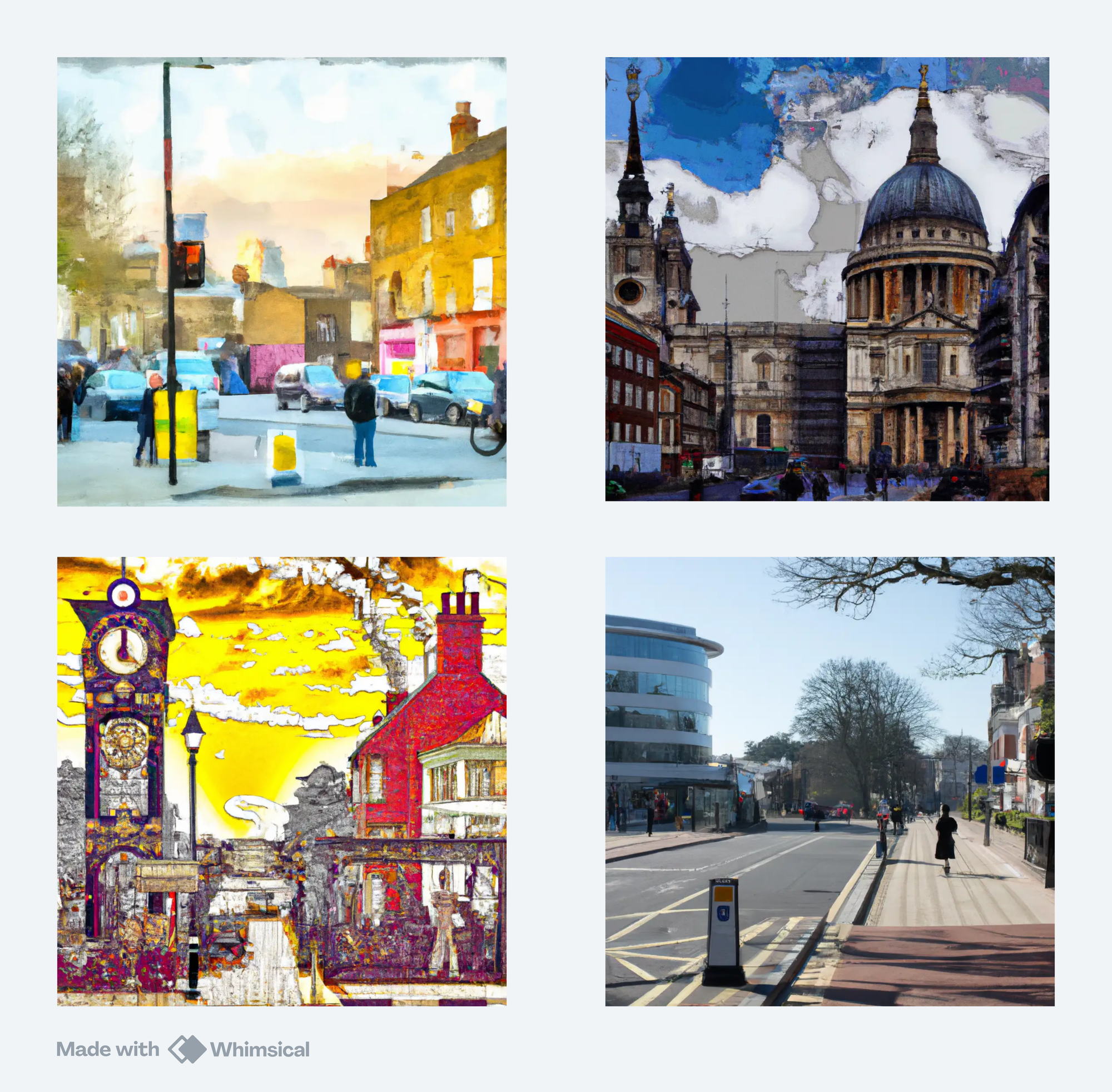

3. 可视化层:把预测变成叙事

预测的结果会被输入到一个 Flask 构建的网站中。

它包含三种信息呈现形式:

- AI生成图像 —— 由 DALL·E API 根据预测参数与艺术风格提示词生成。

- 叙事文字 —— 由语言模型(DeepSeek)根据 SHAP 结果自动生成,如“未来气候播报”或“未来旅人视角”。

- 交互式SHAP气泡图 —— 展示各因素的相对影响力,可点击查看细节。

网站既是展览界面,也是数据归档平台。

观众可以扫码查看自己生成的未来图像,下载并分享。

最终形成一个由公众共同生成的“未来图库”。

展示与反馈:观众的互动反馈

在UCL东校区的 Marshgate 图书馆展览期间,

这台望远镜和其他展品一起摆放在一楼大厅,连续运行了三周,供大众参观。

最初吸引人的是外观:复古望远镜搭配机械旋钮,像一件来自过去的未来机器。

但很多人上手后会花几分钟去“转动时间”,观察不同年份的图像变化。

有的图像是被水淹没的城市,有的则是一片金属森林。

不过我发现一个有趣的现象:

大多数人更关注“画面好不好看”,而不是“为什么会这样”。

他们乐于玩、乐于生成,却不太关心背后的数据。

这提醒了我——

一个有趣的交互并不等于有意义的交流。

如果Obscura No.7 的目标是“引发理解”,就必须在设计中考虑用户的动机路径。

反思

如果把Obscura No.7当作一个产品,它的表现其实非常典型。我借用了 Fogg行为模型[2] 来分析这个现象:

- Trigger(触发)强:实体造型吸睛;旋钮 + 触控的物理交互能迅速把人“拉进来”。

- Ability(能力)足:上手成本低、流程清晰,人人都能完成一次“生成”。

- Motivation(动机)弱于前两者:当前交互主要唤起“审美愉悦”(好玩、好看),尚不足以驱动更深层的理解或长时停留。这与“Piano Stairs[3] → Social Stairs [4]”的研究脉络相似:外部刺激易吸引注意,却难以自然过渡到持久的内在动机。

这意味着:

- 场景化与在地化部署

把系统从短期展陈移到学校、公共空间、社区等场域;让生成结果绑定在地数据与日常语境,弱化“展览新奇感”,强化与使用者生活的关联。 - 信息分层设计(从感性到理性)

以图像先行降低进入门槛;随后分层揭示数字、因子与 SHAP 解释,控制信息节奏,避免“一屏灌输”。 - 共创机制与长期参与

让参与者贡献本地数据/叙事/解读,把“看图”升级为共同构建未来场景;并通过长期部署 + 纵向跟踪,观察是否从好奇转向反思,甚至影响行为。

结语:让未来变得可讨论

Obscura No.7 对我而言,不仅是一台机器,更是一个命题——

“如何用AI,让复杂的未来变得可以被讨论?”

它并不完美,但它让我重新理解了“产品”的含义:

不是把技术做到极致,而是让技术成为沟通的桥梁。

我希望这台望远镜能让人重新思考环境、技术与想象力的关系。

未来不是被预测出来的,而是被想象、被共创、被看见的。

引用

[1] Li, R., Sindikubwabo, C., Feng, Q. and Cui, Y. (2023), ‘Short-term climate prediction overchina mainland: An attempt using machine learning, considering natural and anthropicfactors’, Sustainability 15(10), 7801.

[2]Fogg, B. J. (2009), A behavior model for persuasive design, in ‘Proceedings of the 4th international Conference on Persuasive Technology’, pp. 1–7.

[3] https://www.youtube.com/watch?v=2lXh2n0aPyw

[4]Peeters, M., Megens, C., VanDenHoven, E., Hummels, C.andBrombacher, A.(2013), Social stairs: taking the piano staircase towards long-term behavioral change, in ‘International conference on persuasive technology’, Springer, pp. 174–179